2025年、画像生成AIの世界は劇的な進化を遂げました。

かつて標準だったStable Diffusion 1.5やSDXLを超え、現在はFlux.1による圧倒的な写実描写や、Wan 2.1による高品質な動画生成がトレンドの中心です。

しかし、これらの「次世代モデル」を扱うには、クラウドサービスの検閲やコストから解放されたローカル環境(自宅PC)の構築が不可欠です。

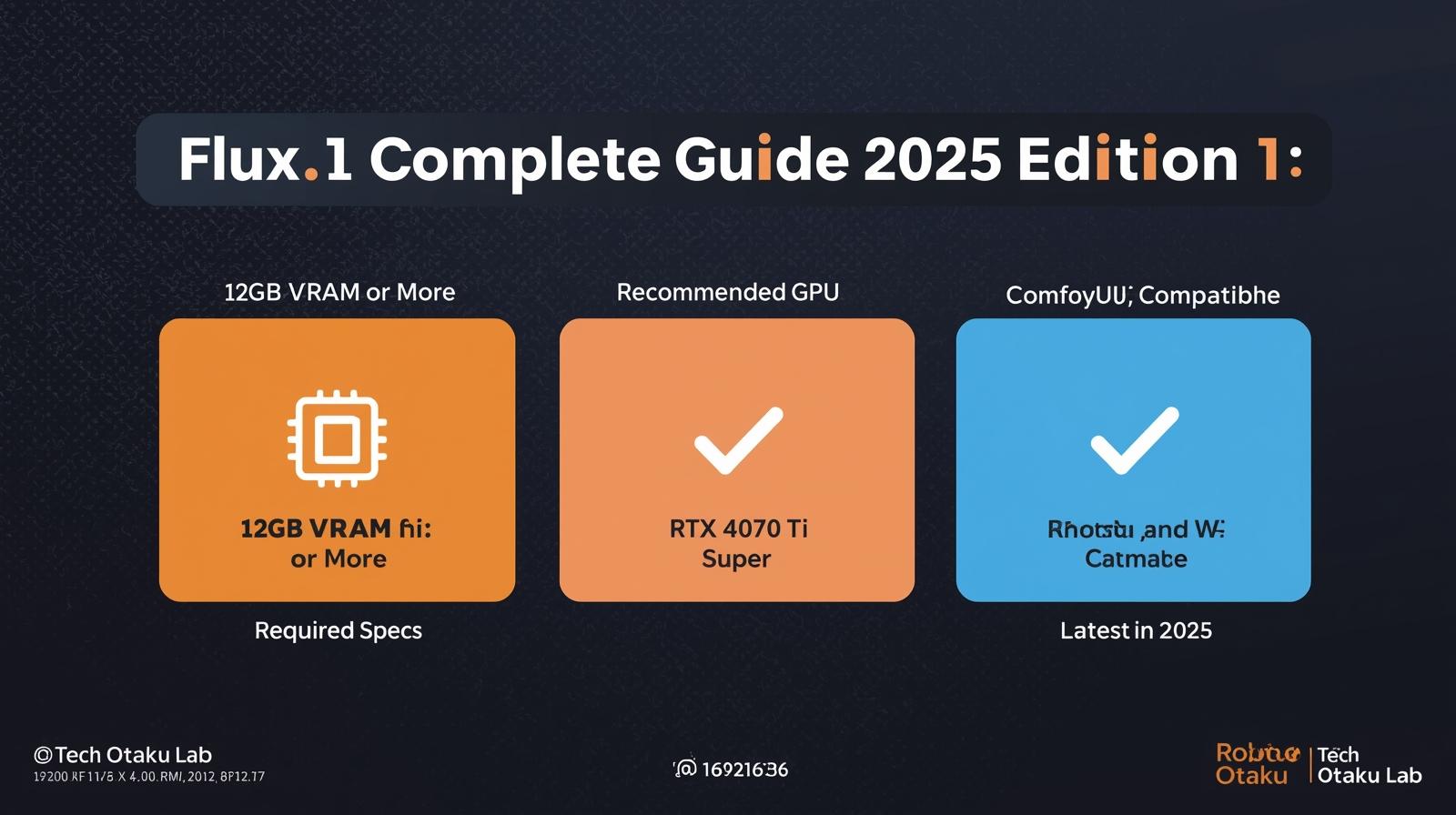

結論から言うと、快適に運用するにはVRAM 12GB以上のGPU(RTX 4070 Ti Super以上)が必須です。本記事では、最新モデルを快適に動かすためのハードウェア選定から、ComfyUIを用いた環境構築までを徹底解説します。

なぜ今、ローカル環境なのか?クラウドとの決別

MidjourneyやDALL-E 3は確かに便利です。しかし実際に使ってみると、「月額2,000円〜6,000円の課金」「生成枚数の上限」「表現の検閲(Censorship)」という壁に直面します。

私自身、Midjourneyの月額60ドルプランを1年間使い続けた結果、年間7万円以上を支払っていました。しかも生成した画像の著作権も曖昧で、商用利用には常に不安がつきまといます。

最初はVRAM 8GBのRTX 3060で環境を組んだのですが、Flux.1 Devモデルを動かそうとすると「CUDA out of memory」エラーで落ちまくりました。結局、RTX 4070 Ti Superに買い替える羽目に。最初から12GB以上にしておけば無駄な出費を防げたというのが痛感した教訓です。

- 完全な自由:ControlNetやLoRAを駆使し、構図や画風を100%コントロール可能。プロンプト制限なし。

- ランニングコストゼロ:初期投資後は電気代のみ。どれだけ生成しても追加料金なし。月1,000枚生成すれば1枚あたり実質0円。

- プライバシー保護:データは外部に送信されない。NSFWを含むあらゆる表現が可能(自己責任)。

- 最新技術への即応:Flux.1やWan 2.1など、オープンソースモデルを即座に試せる。Civitaiから最新モデルをダウンロードして5分後には動く。

- 初期投資が高額:推奨スペックのPCは20万円〜40万円。ただし2年使えば月額換算8,300円〜16,600円で、Midjourney Pro(月額60ドル≒9,000円)より安い。

- セットアップの学習コスト:GitやPythonの基礎知識が必要。最初の環境構築に半日〜1日かかる(この記事で短縮可能)。

- 電気代:RTX 4090フル稼働で1時間約30円。月100時間使っても3,000円程度。

2025年のハードウェア選定戦略:VRAMが全てを支配する

ローカル生成AIにおいて、CPUやメモリも重要ですが、最もクリティカルなのがGPUのVRAM(ビデオメモリ)容量です。

Flux.1のような次世代モデルを扱う場合、従来の「VRAM 8GB」はもはやエントリーラインに過ぎません。実用的な快適さを求めるなら、最低でもVRAM 12GB、理想は24GBです。

【重要】2025年版 推奨VRAMスペック表

最新のFlux.1およびWan 2.1の運用実績に基づき、推奨スペックを明確化しました。

| クラス | VRAM容量 | 代表GPU(2025年最新) | 実売価格帯 | Flux.1 / Wan 2.1 運用能力 |

|---|---|---|---|---|

| エントリー | 8GB – 10GB | RTX 4060 / 3060 | 3.5万円〜5万円 | 非推奨。量子化(GGUF/FP8)必須。512×512程度が限界。動画生成は実質不可能。 |

| スタンダード | 12GB – 16GB | RTX 4070 Ti Super / 4070 Super | 9万円〜12万円 | 実用的。Flux.1 DevがFP8で快適動作(1024×1024で約40秒/枚)。ControlNet併用も可能。 |

| ハイエンド | 24GB | RTX 4090 / 3090 | 25万円〜35万円 | 完全体験。2048×2048の超高解像度、Wan 2.1での動画生成、LoRA学習まですべて快適。プロレベル。 |

VRAM不足は単に「遅くなる」だけではありません。生成途中でクラッシュ(CUDA out of memory)し、数分待った挙げ句すべてが水の泡になります。私は何度これで時間を無駄にしたことか…。快適に使うなら、VRAM 12GB以上(RTX 4070 Ti Super以上)を強く推奨します。

GPU以外の推奨スペック

| パーツ | 推奨スペック | 理由 |

|---|---|---|

| CPU | Intel Core i5-13400以上 / Ryzen 5 7600以上 | 画像生成はGPU依存だが、ComfyUIのノード処理やバックグラウンド作業で必要。 |

| メモリ | 16GB以上(推奨32GB) | モデル読み込み時にシステムRAMも使用。ブラウザや他ソフトと並行作業するなら32GB。 |

| ストレージ | SSD 500GB以上(推奨1TB) | モデルファイル(Flux.1 Devだけで23GB)が巨大。複数モデルを保管するなら1TB必須。 |

【2025年版】おすすめBTOパソコン|画像生成AI特化モデル

自作PCに不安がある方には、クリエイター向けBTOパソコンが最適解です。以下は実際に画像生成AIユーザーから高評価を得ているメーカーです。

国内No.1信頼性マウスコンピューター G-Tune / DAIV

国内サポートが手厚く、クリエイター向けPCとして信頼性が高いブランド。特にDAIVシリーズは動画・画像編集に最適化されています。

- おすすめモデル:DAIV Z7-G70(RTX 4070 Super / メモリ32GB)

- 価格帯:約27万円〜(セール時25万円台)

- 強み:3年間の無償保証、24時間365日電話サポート

コスパ最強FRONTIER(フロンティア)

セール時期の価格破壊力が圧倒的。同じ予算でワンランク上のGPUを狙うなら必ずチェックすべきメーカーです。

- おすすめ:月替わりセール(毎月第1金曜更新)

- 実例:RTX 4070 Ti Super搭載で23万円台(通常28万円相当)

- 注意点:セール品は数量限定のため、見つけたら即決推奨

BTOパソコンはボーナス時期(6月・12月)や年末年始、新生活シーズン(3月)に大規模セールが集中します。急ぎでなければ、これらの時期を狙うと同じスペックで3万円〜5万円安く買えることも。特にFRONTIERは値引き幅が大きいです。

ソフトウェア環境の構築:ComfyUI一択の理由

2025年現在、従来のWebUI(Automatic1111 / Forge)から、ノードベースのComfyUIへの移行が加速しています。

なぜComfyUIなのか?答えはシンプルで、「最新モデルへの対応が世界最速」だからです。Flux.1が公開された翌日には、すでにComfyUI用のカスタムノードが公開されていました。

- メモリ効率が異次元:同じVRAMでWebUIの1.5倍〜2倍の解像度を扱える。実測でRTX 4070 Ti SuperでFlux.1が1024×1024で約40秒(WebUIなら80秒以上)。

- 最新技術への即応性:FluxやWan 2.1など、最新モデルへの対応速度が圧倒的。

- ワークフローの柔軟性:ControlNet + LoRA + IP-Adapterなど、複雑な処理を視覚的に組み立てられる。

- バッチ処理が強力:一度ワークフローを作れば、プロンプトだけ変えて100枚連続生成も可能。

- 初見殺しのUI:ノード接続という概念に慣れるまで1〜2日かかる。YouTubeチュートリアル必須。

- 日本語情報が少ない:公式ドキュメントは英語メイン。ただし2025年は日本語解説動画が急増中。

【完全版】ComfyUI環境構築手順(Windows向け)

Pythonのバージョン競合トラブルを避けるため、公式Portable版(スタンドアロン型)を使用するのが最も安全です。以下、初心者でも失敗しない手順を解説します。

GitHubの公式リリースページからComfyUI_windows_portable_nvidia_cu121_or_cpu.7zをダウンロードします。ファイルサイズは約3GBなので、回線速度によっては10分程度かかります。

日本語を含むパス(例:C:\Users\山田太郎\Downloads\)はエラーの原因になります。必ず半角英数のみのパスに解凍してください。推奨はC:\ComfyUI\です。

解凍したフォルダ内のrun_nvidia_gpu.batをダブルクリック。黒い画面(コマンドプロンプト)が出て、自動的にブラウザが開けば成功です。初回起動は依存関係のダウンロードで3〜5分かかります。

拡張機能管理ツール「ComfyUI Manager」は必須です。これがあれば、ワンクリックで新しいノードをインストールできます。

上記コマンドを実行後、ComfyUIを再起動すると、右下に「Manager」ボタンが出現します。

CivitaiまたはHugging Faceから、Flux.1のモデルファイルをダウンロードします。

- Flux.1 [Dev]:非商用(研究・個人利用OK)、最高画質、ファイルサイズ約23GB

- Flux.1 [Schnell]:商用可能(Apache 2.0ライセンス)、高速版、約11GB

ダウンロードしたファイルはComfyUI\models\checkpoints\フォルダに配置します。

ComfyUI Managerから「Flux.1 Simple Workflow」を検索してインストール。プロンプト欄にa cat wearing sunglasses on a beachと入力して「Queue Prompt」をクリック。30秒〜1分で画像が生成されれば成功です。

既存のWebUI(ForgeやA1111)を使っている場合、

extra_model_paths.yaml.exampleをextra_model_paths.yamlにリネームし、以下を追記することで、巨大なモデルファイルをコピーせずに共有できます。

stable_diffusion:

checkpoints: "D:/StableDiffusion/models/Stable-diffusion/"

loras: "D:/StableDiffusion/models/Lora/"

これでSSD容量を100GB以上節約できます。

2025年の主役モデル:Flux.1 vs Wan 2.1 徹底比較

Flux.1:写実性の到達点

Black Forest Labs(元Stability AIのコアメンバーが設立)が開発したFlux.1は、2024年8月の登場以来、画像生成AIの頂点に君臨しています。

| 項目 | Flux.1の強み | 従来モデル(SDXL)との差 |

|---|---|---|

| プロンプト理解力 | 複雑な英文も正確に反映 | SDXLは長文プロンプトで破綻しがち |

| 文字描写 | 看板やポスターの文字が読める | SDXLは文字が崩れる |

| 人体描写 | 指が6本問題がほぼ解消 | SDXLは頻繁に崩壊 |

| 光と影 | 写真と見分けがつかないレベル | SDXLは「CG感」が残る |

- Flux.1 [Dev]:非商用ライセンス(個人の趣味、研究用途のみ)。画質は最高峰。Step数25〜30推奨。

- Flux.1 [Schnell]:商用利用OK(Apache 2.0)。高速化に特化し、Step数4でも高品質。ビジネス用途ならこちら。

Wan 2.1:動画生成の新時代

Alibaba Cloud発のWan 2.1は、140億パラメータ(14B)を持つ次世代動画生成モデルです。2025年1月にリリースされ、わずか2ヶ月でRunwayやPika Labsの牙城を揺るがしています。

| 機能 | Wan 2.1 | Runway Gen-3(クラウド) |

|---|---|---|

| Text-to-Video | 5秒/80フレーム 無料 | 5秒/クレジット消費(月額95ドル〜) |

| Image-to-Video | 高精度、破綻なし | 同等レベル |

| 解像度 | 最大1280×720 | 1280×768 |

| 必要VRAM | 16GB以上推奨(FP8量子化で12GBでも可) | クラウドのためPC不要 |

Flux.1で生成した美しい静止画を、Wan 2.1に読み込ませることで、表情の変化、髪のなびき、背景の微細な動きまで自然に再現できます。これにより「静止画→動画」のワークフローが個人レベルで完結します。

まとめ:最強の「外部脳」をPCの中に

Flux.1とWan 2.1を組み合わせることで、個人のPCがハリウッド級の制作スタジオに変貌します。クラウドサービスに年間10万円以上を支払い続けるか、それとも一度だけ30万円を投資して永続的な資産を手に入れるか。

この環境を構築するために投資すべきは、間違いなくGPU(VRAM)です。私の失敗から学んでください:VRAM 8GBは2025年では時代遅れです。最低12GB、理想は24GB。

「まずはRTX 4060で様子見」という考えは、高確率で後悔します。私がそうでした。結局、半年後にRTX 4070 Ti Superに買い替え、差額で実質6万円を無駄にしました。最初から必要スペックを買う方が、トータルコストは安くなります。

自身のクリエイティビティを解き放つために、まずはBTOパソコンのセール情報をチェックすることから始めてみてはいかがでしょうか。

コメント