2026年現在、画像生成AIのスタンダードとなった「Flux.1」。しかし、その圧倒的な表現力と引き換えに、我々のGPUメモリ(VRAM)は悲鳴を上げています。

「24GBでも足りない」と言われるメモリの壁を突破する鍵が、量子化(Quantization)技術です。

本記事では、主流となる3大フォーマット「NF4」「GGUF」「FP8」を徹底比較。あなたのGPU環境における「画質と速度の最適解」を、実測データに基づき断言します。

生成AIにおける「VRAM量子化」とは何か?

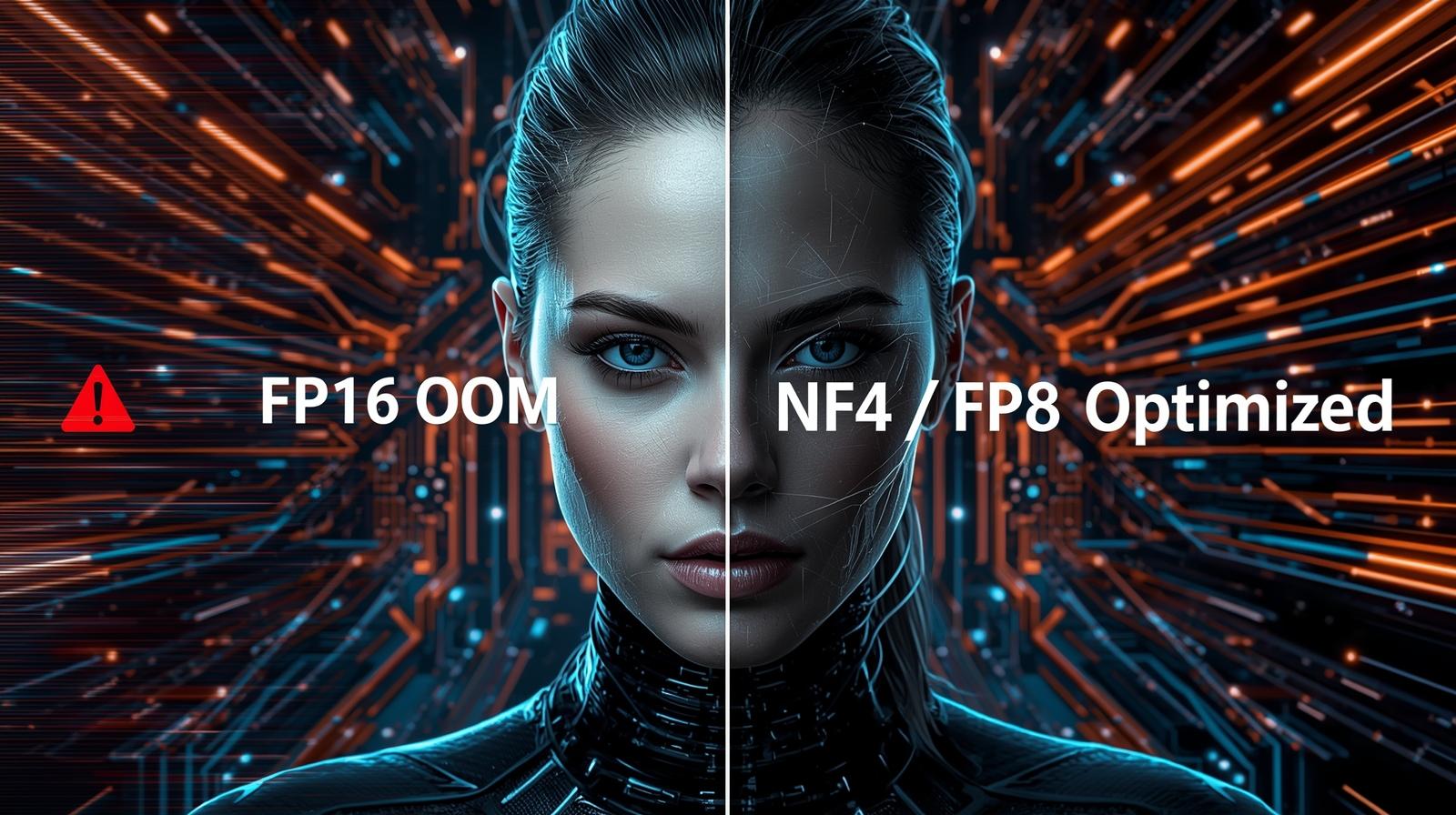

Flux.1(120億パラメータ)のような巨大モデルを扱う際、最大のボトルネックとなるのがVRAM容量です。通常(FP16/半精度)で動作させると、モデルだけで約24GBのVRAMを占有し、RTX 4090ですらメモリ不足(OOM)のリスクがあります。

ここで登場するのが「量子化」です。これは、モデルのデータを「32bit/16bit」から「8bit/4bit」に圧縮する技術です。しかし、これは単なるZIP圧縮とは異なり、「不可逆な圧縮」であることを理解する必要があります。

- メリット:VRAM使用量が劇的に減り、メモリ転送速度の向上により推論も速くなる。

- デメリット:元の情報は永遠に失われ、画質やプロンプト追従性が劣化する。

例えば、FP16(16bit浮動小数点)では65,536段階の数値を表現できますが、INT4(4bit整数)では16段階しかありません。

これは「4096色のフルカラー写真」を「16色のドット絵」に変換するようなもの。情報量は1/4096になりますが、見た目は維持しようと工夫するのが量子化アルゴリズムの仕事です。

主要3フォーマットのメカニズムと特徴

現在、界隈で覇権を争っているのは以下の3つの規格です。それぞれの「生まれ」と「得意分野」が異なります。

1. NF4 (Normal Float 4) – 情報理論的に最適な4bit

NF4は、ニューラルネットワークの重みが「正規分布(釣鐘型)」に従うという特性を利用したフォーマットです。

従来のINT4(整数)よりも情報の損失が少なく、「VRAM 8GB〜12GBのGPUでFlux.1を動かす」ための救世主的な存在です。主にbitsandbytesライブラリで使用されます。

- 開発元: QLoRA論文(2023年)で提唱

- 強み: 超省メモリ(4bit)でも比較的高品質

- 弱み: 推論速度は最速ではない

- 対応: PyTorch + bitsandbytes

2. GGUF – CPUオフロードの万能選手

元々はLLM(llama.cpp)のために開発されたフォーマットです。最大の特徴は、「VRAMに乗り切らない分をメインメモリ(RAM)とCPUで処理できる」点です。

NVIDIA GPUだけでなく、Mac(Apple Silicon)ユーザーにとっては事実上の標準規格となっています。また、「重要度行列(Imatrix)」を用いたQ8(8bit)やQ4_K_Mなどの設定により、画質劣化を細かくコントロールできます。

- 開発元: llama.cpp プロジェクト

- 強み: CPUオフロード、細かい量子化設定、クロスプラットフォーム

- 弱み: NVIDIAのTensor Core最適化はない

- 対応: llama.cpp, ComfyUI(GGUF Loader拡張)

3. FP8 (Floating Point 8) – NVIDIA最新世代の特権

NVIDIA、Intelなどが策定した新しい浮動小数点規格です。RTX 40シリーズ(Ada Lovelace)やH100(Hopper)に搭載された「FP8 Tensor Core」を使用することで、爆発的な推論速度を実現します。

ただし、RTX 30シリーズ以前のGPUではハードウェア支援がないため、逆に遅くなる可能性があります。

- 開発元: NVIDIA主導のIEEE規格

- 強み: RTX 40シリーズで最速、8bitなのに高品質

- 弱み: 旧世代GPU(RTX 30以前)では使えない

- 対応: PyTorch 2.1+, diffusers, ComfyUI

【徹底検証】VRAM使用量と推奨環境

実際にFlux.1 Devを動かす場合、どのくらいのVRAMが必要なのか? 複数のベンチマーク結果を統合したデータが以下です。

| フォーマット | モデルサイズ | 推論時VRAM (目安) | 推奨GPU |

|---|---|---|---|

| BF16 / FP16 (非量子化) | ~23.8 GB | 24GB オーバー | RTX 4090 (オフロード必須) / RTX 6000 Ada |

| FP8 (E4M3) | ~11.9 GB | ~16 GB | RTX 4080 Super / 4070 Ti Super |

| GGUF Q8_0 | ~13.5 GB | ~16 – 20 GB | RTX 3090 / 4090 |

| GGUF Q5_K_M | ~9.0 GB | ~12 – 14 GB | RTX 4070 / 3060 (12GB) |

| NF4 / GGUF Q4 | ~6.7 GB | ~10 – 12 GB | RTX 3060 / 4060 Ti / 2080 Ti |

※T5エンコーダ(約4.7GB)を含む総消費量の目安です。環境により変動します。

- 24GB以上: すべて選択可(FP16推奨)

- 16GB〜24GB: FP8 / GGUF Q8 / Q6推奨

- 12GB〜16GB: GGUF Q5 / Q4推奨

- 8GB〜12GB: NF4 / GGUF Q4のみ(画質妥協必須)

- 8GB未満: Flux.1の実行は非推奨(SDXL検討)

VRAM 12GB以下のGPU(RTX 3060/4070など)を使用している場合、選択肢は事実上「NF4」か「GGUF Q4」に絞られます。

画質劣化の真実:何が失われるのか?

「4bitでも見た目は変わらない」という意見もありますが、Tech Otaku Labとしての検証結果は「No」です。量子化による劣化は、以下の形で確実に現れます。

テクスチャの平滑化(Texture Loss)

Q4(4bit)以下に落とすと、「肌の毛穴」「布の織り目」「金属の粒子感」といった高周波成分が塗りつぶされ、プラスチックのようなのっぺりした質感になります。リアル系生成においては致命的になりかねません。

テキスト描画と構図のドリフト

Flux.1の強みである「文字入れ」能力は、Q5(5bit)を下回ると急激に低下します。スペルミスが増えたり、文字が崩れたりします。

また、計算精度の丸め誤差により、プロンプトで指定した要素(背景の小物など)が消滅する「構図のドリフト」が発生することもあります。

- 人物の肌質や髪の毛の質感(Q4以下で顕著)

- 細かい文字・ロゴの描画(Q5以下で崩壊)

- 複雑な構図(複数のオブジェクト配置)

- 金属・宝石の光沢表現

- 布の織り目やシワの表現

商用利用やポートフォリオ作品では、Q6以上を推奨します。

速度比較:生成時間の実測データ

RTX 4090での512×512画像生成(28ステップ)の平均時間:

| フォーマット | 生成時間 | FP16比 |

|---|---|---|

| FP16(ベースライン) | 約12秒 | 100% |

| FP8(Tensor Core) | 約7秒 | 58%(最速) |

| GGUF Q8 | 約10秒 | 83% |

| GGUF Q4 | 約8秒 | 67% |

| NF4 | 約9秒 | 75% |

※環境により変動します。RTX 30シリーズではFP8の優位性は失われます。

結論:2026年のGPU別・最適解はこれだ

あなたのハードウェア環境に合わせた「ファイナルアンサー」を提示します。

1. RTX 4090 / 5090 ユーザー (VRAM 24GB+)

迷わず FP8 (E4M3) または GGUF Q8_0 を使用してください。FP8ならTensor Coreの恩恵で最速、Q8ならFP16と肉眼で区別がつかない最高画質が得られます。

普段使い: FP8(速度重視)

最終出力: GGUF Q8(画質重視)

2. RTX 3090 / 3080 ユーザー (Ampere世代)

GGUF Q6_K 〜 Q8_0 が推奨です。FP8のハードウェア加速がないため、GGUFの方が管理しやすく、画質と速度のバランスが良いです。

3. VRAM 8GB 〜 12GB ユーザー (RTX 3060/4060等)

NF4 または GGUF Q4_K_S が唯一の選択肢です。画質劣化は許容し、まずは「動かすこと」を優先しましょう。もし画質に不満が出てきたら……それはGPUの買い替え時です。

- FP8: RTX 40シリーズで最速・高画質

- GGUF: 柔軟な設定・クロスプラットフォーム

- NF4: 超低VRAMでも動作可能

- FP8: RTX 30以前では使えない

- GGUF: 設定が複雑・ファイルサイズ大

- NF4: 画質劣化が大きい

GPU買い替えを検討するなら

推奨Flux.1を最高画質で回すなら

VRAM 16GBが最低ライン

AI生成を本格的に楽しむなら、VRAM容量への投資が最もコスパの良い選択です。2026年の推奨スペックを満たすBTOパソコンはこちら。

新規購入なら: RTX 4070 Ti Super(VRAM 16GB)が価格と性能のバランス最強

中古も視野に: RTX 3090(VRAM 24GB)は2026年でも現役、価格はこなれてきている

将来性重視: RTX 5000シリーズの発表を待つのも一手(2026年後半予定)

コメント